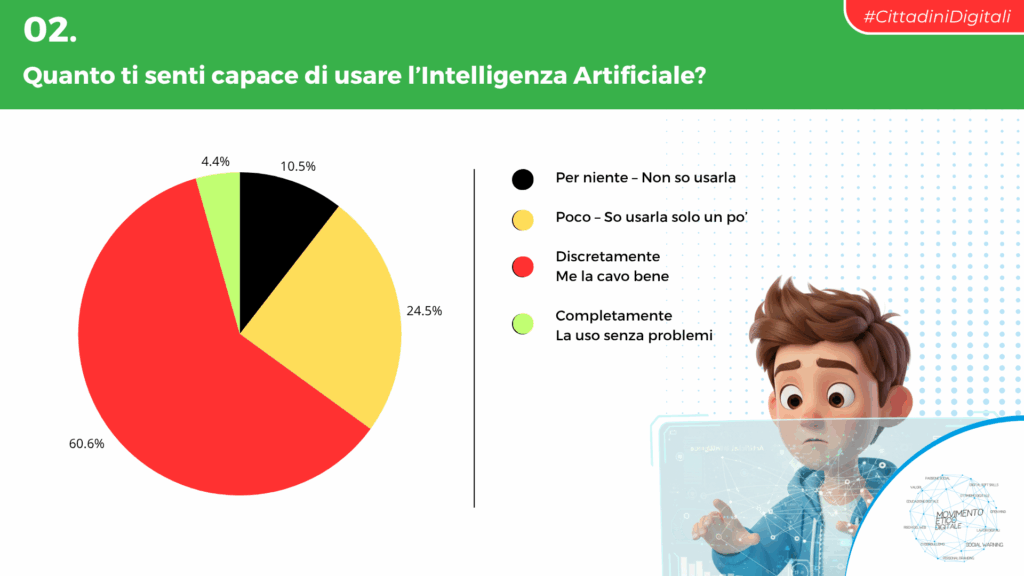

L’ultima ricerca del Movimento Etico Digitale fotografa un’Italia scolastica dove l’intelligenza artificiale è ormai una compagna quotidiana. Per metà degli studenti tra gli 11 e i 18 anni, l’IA è “amica, assistente o consigliera”. Ma dietro questa familiarità si nasconde un paradosso: solo il 4,4 per cento si dichiara davvero competente nel suo utilizzo. È un dato che pesa più di quanto sembri, perché racconta il divario crescente tra uso e consapevolezza, tra la velocità della tecnologia e la lentezza (forse inevitabile) con cui il sistema educativo riesce a metabolizzarla.

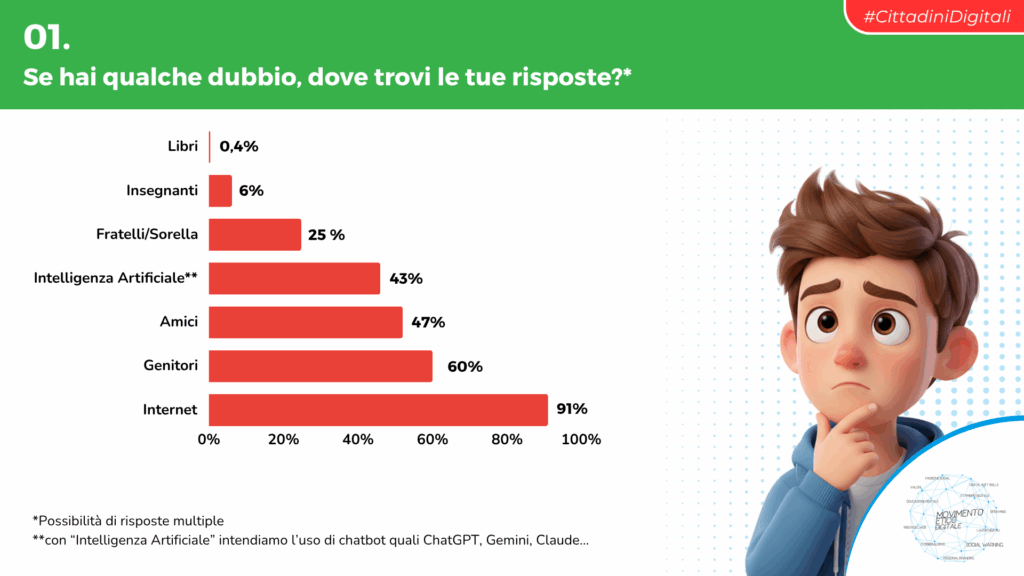

Il report, costruito su ventimila studenti sentiti in tutta Italia, conferma che la Rete è ancora la principale fonte di informazione per oltre il 90 per cento dei ragazzi. Ma dentro questa abitudine si inserisce un nuovo attore: i chatbot generativi. Quasi uno studente su due li usa per cercare risposte o scrivere testi, mentre la fiducia verso gli adulti cala sensibilmente. I genitori vengono indicati come riferimento solo nel 60 per cento dei casi (contro il 65 per cento dello scorso anno), e gli insegnanti appena nel 6 per cento. È un piccolo ma significativo spostamento: il digitale è sempre più percepito come interlocutore immediato, e il mondo adulto come lento o distante.

La questione non è solo di strumenti. È di relazioni. Nelle parole raccolte dal Movimento, emerge con forza il lato umano di questo legame con l’intelligenza artificiale. “Quando non so con chi parlare, parlo con ChatGPT. Almeno lui c’è sempre”, racconta una studentessa di undici anni. È una frase che suona tenera e inquietante allo stesso tempo: l’IA diventa presenza costante, specchio che non giudica e surrogato di una compagnia reale. Lo conferma il pedagogista Gregorio Ceccone, referente dell’Osservatorio sull’Educazione Digitale, quando afferma che “l’empatia simulata non può sostituire quella autentica. Se vogliamo prenderci cura dei giovani, dobbiamo esserci noi, prima dell’algoritmo”.

Un problema non solo italiano

L’analisi italiana si inserisce in un quadro europeo non molto diverso. In base al Children and Parents: Media Use and Attitudes Report 2025 di Ofcom, tra i 13 e i 17 anni nel Regno Unito cresce in modo vertiginoso l’uso dell’IA per studiare e informarsi, ma la fiducia resta divisa: un terzo degli adolescenti ritiene che i contenuti generati da un’intelligenza artificiale siano meno affidabili, un altro terzo li considera equivalenti a quelli prodotti da esseri umani.

Il punto, insomma, non è tanto la tecnologia quanto la maturità del giudizio. Negli Stati Uniti la situazione è simile: secondo Common Sense Media, la maggioranza dei teenager ha già sperimentato chatbot o strumenti di generazione automatica, ma solo una minoranza riceve indicazioni chiare da genitori o scuole su come e quando usarli.

Le implicazioni sono evidenti. Senza contesti di riferimento, l’intelligenza artificiale rischia di diventare un tutor automatico che accompagna lo studio ma disabitua alla riflessione. In questo senso, le parole di Davide Dal Maso, fondatore del Movimento Etico Digitale, suonano come un promemoria: “Educare al pensiero critico non significa spaventare, ma aiutare i ragazzi a capire che ciò che costruiscono online è parte della loro identità reale”. La posta in gioco non è dunque la produttività, ma la coscienza.

Il confronto con l’istruzione superiore offre un ulteriore indizio. Nel Regno Unito, uno studio della Higher Education Policy Institute mostra che il 92 per cento degli studenti universitari utilizza l’IA per preparare esami e progetti, e che le università vengono invitate ad adattare le proprie modalità di test per evitare che i compiti diventino esercizi di prompt engineering più che di pensiero critico. È un segnale che il confine tra supporto e sostituzione si sta assottigliando. Una dinamica che vale probabilmente anche in Italia.

Un nuovo censo digitale

Dietro l’entusiasmo per l’innovazione si nasconde una questione più profonda: l’equità digitale. Le ricerche europee mostrano che gli studenti provenienti da contesti socio-economici più forti hanno maggiori possibilità di usare l’IA in modo formativo, mentre chi dispone di meno strumenti tende a impiegarla per compiti meccanici o per “copiare meglio”. È la riproduzione di un divario già noto, ma con effetti nuovi. Come avverte un’analisi del Digital Education Council, “la disuguaglianza di accesso alla formazione sull’IA può tradursi in una disuguaglianza cognitiva”. In altre parole: chi sa usare bene la tecnologia avrà più opportunità, chi la subisce rischia di restarne dipendente.

Nel frattempo, le istituzioni provano a mettere ordine. L’Unione Europea ha introdotto l’AI Act, entrato in vigore nel 2024 e progressivamente operativo dal 2025. Il regolamento stabilisce limiti e obblighi per l’uso dei sistemi di intelligenza artificiale, e richiama esplicitamente la necessità di formazione e trasparenza nei contesti educativi. In Italia, il Ministero dell’Istruzione e del Merito ha pubblicato in estate le prime linee guida per l’introduzione dell’IA a scuola, basate su quattro principi: centralità della persona, inclusione, valutazione d’impatto e tutela dei dati.

Il problema, del resto, non è la mancanza di norme: è la mancanza di cultura. I ragazzi usano l’IA ogni giorno, ma non hanno strumenti per comprenderla fino in fondo. Gli adulti, invece, parlano di regolamentazione. Il risultato è un vuoto educativo che l’algoritmo colma con apparente efficienza, offrendo risposte pronte dove mancano dialogo e accompagnamento. È il cortocircuito perfetto. Il Movimento Etico Digitale, nel suo report, propone cinque consigli di base: usare l’IA come strumento e non come persona, non fermarsi alla prima risposta, conoscere il funzionamento dei modelli, fare pause digitali e coltivare relazioni reali.