Siri, Alexa & co hanno ancora molti problemi in termini di bias, stereotipi, nelle risposte e nelle impostazioni di base che le dipingono come remissivi soggetti femminili: indigo.ai è uno strumento per progettare chatbot consapevoli

Se ne parla da alcuni anni. Da quando alle intelligenze artificiali che ci seguono ormai in tutte le nostre attività quotidiane è stata assegnata, di defult e in prevalenza, una serie di voci femminili. L’accusa più forte era per esempio arrivata un paio di anni fa da parte dell’Unesco, l’Organizzazione delle Nazioni unite per educazione, scienza e cultura. Nella ricerca, battezzata “I’d blush if I could: closing gender divides in digital skills through education”, “Arrossirei se potessi”, sottolineava diversi aspetti controversi della manifestazione esteriore di queste soluzioni tecnologiche: risposte remissive e civettuole (anche alle affermazioni violente degli utenti), oltre ovviamente al timbro vocale costantemente femminile e i nomi in prevalenza femminili contribuirebbero a rafforzare i pregiudizi e l’idea che le donne debbano avere un ruolo subordinato.

Il problema è che “nella maggior parte dei casi la voce degli assistenti vocali è femminile trasmette il messaggio che le donne sono compiacenti, docili e ansiose di aiutare, disponibili semplicemente toccando un pulsante o attraverso un comando smozzicato come “ehi” oppure “ok” – si leggeva in quella ricerca – l’assistente non può fare nulla al di fuori di ciò che l’utente gli chiede. Compie gli ordini e risponde alle domande indipendentemente dal tono o dall’ostilità. In molte comunità, ciò rinforza i comuni pregiudizi di genere secondo cui le donne sono condiscendenti e tolleranti nei confronti di trattamenti inadeguati”.

Le radici del gender gap

Il problema del gender gap nasce, ovviamente, ben prima dell’intelligenza artificiale, nel mondo reale. La fotografia scattata dal Gender Equality Index di Bloomberg lascia d’altronde poco margine d’interpretazione: ad esempio, solo 23 delle 380 società analizzate hanno un amministratore delegato donna. E la presenza femminile all’interno dei consigli d’amministrazione non arriva al 30%. Un fenomeno trasversale, che affonda le radici in tutti i settori. Quello tecnologico non fa eccezione, come dimostra uno studio di LivePerson riportato da indigo.ai, piattaforma di Conversational AI che progetta e costruisce assistenti virtuali, tecnologie di linguaggio ed esperienze conversazionali.

LivePerson ha chiesto a un campione di consumatori statunitensi di indicare una donna leader nel settore tech: il 91,7% non è stato in grado di dare una risposta e – peggio – un quarto di chi ha affermato di conoscere una top manager del comparto ha poi indicato Siri o Alexa. Sì, esatto: gli assistenti vocali rispettivamente di Apple e Amazon. “Un quadro desolante, che si rispecchia anche nel mondo virtuale – aggiunge indigo.ai – le grandi aziende che utilizzano i chatbot e gli assistenti, che quotidianamente interagiscono con le persone, spesso li commissionano senza considerare l’impatto che possono avere sulla comunità. Una superficialità che ha contribuito a rafforzare una serie di stereotipi legati a razza, età e soprattutto genere”.

Quello delle assistenti virtuali rischia insomma di trasformarsi in un (neanche troppo) sottile servilismo che porta nelle centinaia di richieste quotidiane, e in modo purtroppo perfetto, i tanti pregiudizi di genere che condizionano il mondo della tecnologia e la società intera e che diventano ancora più evidenti nel gap delle competenze digitali. Anche perché il risultato di questi sistemi è quello di rendere le donne il “volto” di difetti ed errori che derivano dai limiti di hardware e software progettati prevalentemente da uomini. E questo è il problema di fondo del settore.

Servono chatbot designer consapevoli

“Oggi le donne hanno il 25% di probabilità in meno rispetto agli uomini di imparare come sfruttare la tecnologia digitale per scopi di base, 4 volte meno la probabilità di sapere come programmare un computer e 13 volte in meno la probabilità di depositare un brevetto tecnologico. Una lacuna che dovrebbe suonare come un campanello d’allarme nel momento in cui la tecnologia pervade ogni settore economico” spiega il gruppo. Ricordando come l’attenzione sia per fortuna alta e la lotta agli stereotipi e l’attenzione a diversità e inclusione siano ormai capisaldi di gran parte di aziende, grandi brand e organizzazioni. Anche nell’apparentemente piccolo ambito degli (anzi, delle) assistenti digitali occorre però fare passi avanti. L’intelligenza artificiale può infatti alimentare i bias o combatterli. “Di certo le aziende non possono scegliere di restare neutrali: devono cercare di affidarsi a chatbot designer che siano consapevoli del concetto di bias e che sappiano progettare le macchine in modo da evitare quanto più possibile che l’assistente creato diventi, ancora una volta, il veicolo di messaggi sbagliati”.

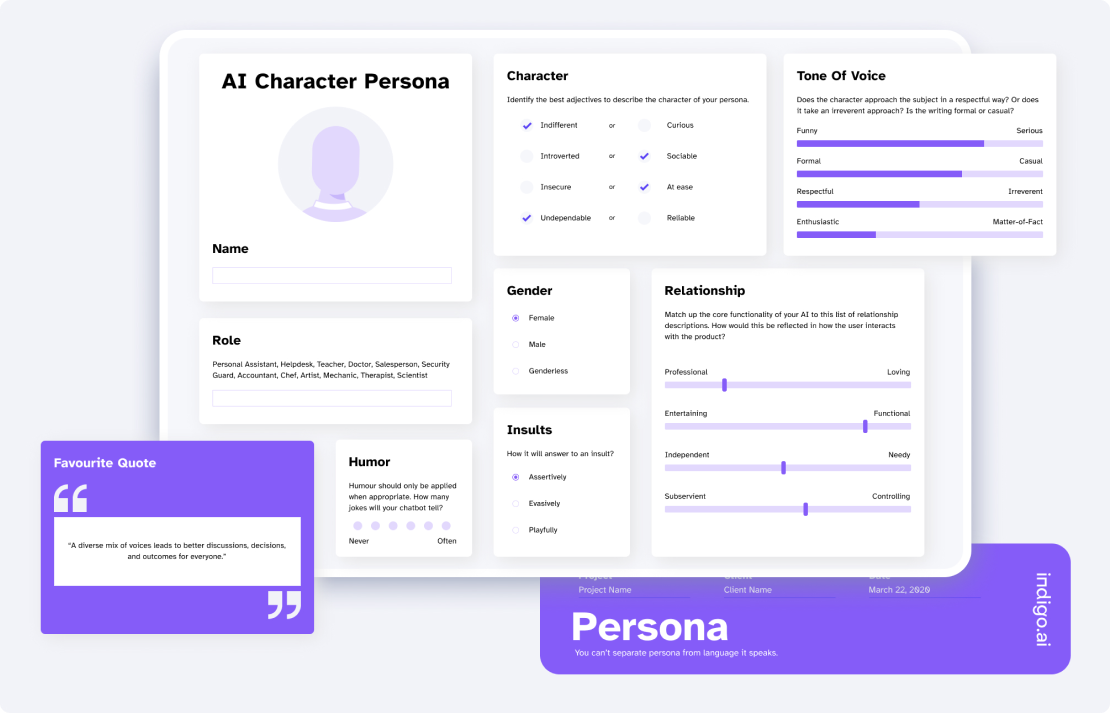

La responsabilità è in capo alle aziende, ma anche nelle mani degli sviluppatori. Imprese e istituzioni devono affidarsi a chi può progettare e creare assistenti virtuali in grado di elaborare un linguaggio naturale, scevro da condizionamenti, e capace di ribellarsi ai pregiudizi. È possibile, insomma, creare dei modelli di valutazione del bias di un chatbot o intelligenza artificiale. Indigo.ai ci prova con una piattaforma battezzata ChatbotPersona. Si tratta di un tool studiato per definire ogni aspetto della personalità del chatbot. Vale a dire “uno strumento che può fare la differenza e aiutare nel processo di democratizzazione degli assistenti virtuali, segnalando tutte quelle azioni dell’assistente virtuale che sono state programmate in modo involontariamente sessista, o razzista, e indicando una strada alternativa”. Un tool che ha è già stato utilizzato nel percorso di studi della Naba (Nuova Accademia di Belle Arti) insieme agli studenti di design management, per guidarli nella progettazione di interfacce conversazionali costruite attorno alle esigenze degli utenti e, allo stesso tempo, attente agli aspetti etici. Un segnale di come sia possibile, anche da quel punto di vista, cambiare voce.