Dalle scuole alle università cresce l’allarme per l’impiego di ChatGPT nella stesura di testi e tesi di laurea. Intanto i programmi a disposizione per scovare le opere create dall’AI hanno ancora strada da fare. Ecco perché

Che i contenuti prodotti dall’intelligenza artificiale nelle sue diverse declinazioni – che si tratti dei modelli linguistici generativi di Open AI o di quelli grafici di Stable Diffusion dell’LMU di Monaco – siano poco affidabili è chiaro a occhio nudo. Basta una media competenza linguistica e un’altrettanto modesta cultura di base. Eppure, quando la loro produzione e diffusione si farà più pervasiva, l’industria dei contenuti (chi li fa per mestiere, chi li commissiona e perché no, chi li legge) avrà un grosso problema: come distinguere l’umano dall’artificiale? Come capire se un testo o un’illustrazione è stata partorita da una delle tante piattaforme sempre più accessibili all’utente comune alle prese con “prompt”, cioè comandi, sempre più semplici da formulare?

Tutto questo senza considerare, a prescindere dalla qualità o dall’affidabilità del contenuto, il valore legale di un elaborato originale in caso di tesi, concorsi, lavori e prove di altro tipo: come accertarsi che l’opera presentata per esempio da uno studente alla fine del percorso accademico sia davvero farina del suo sacco? Per non parlare di compiti e tesine alle scuole superiori.

All’università di Firenze, riportano le cronache recenti, qualche dubbio è già venuto a diversi professori e l’azienda che i docenti già pagano per scovare gli eccessi di copia-incolla (si tratta del software antiplagio Compilatio) dovrebbe sviluppare a breve un tool utile anche nel caso dell’intelligenza artificiale. Anzi, si può già testare qui.

AI Text Classifier

Ma è un lavoro ben più complesso e che soprattutto la stessa OpenAI ha già affrontato. Fornendoci non solo il chatbot ChatGPT ma anche il suo antidoto: AI Text Classifier, una piattaforma dove incollare il testo sospetto e ricevere la diagnosi. Non solo: insieme al sospetto che un lavoro sia stato partorito dall’intelligenza artificiale spesso il sistema della società californiana inserisce anche i riferimenti-fonte, cioè i testi di partenza impiegati per elaborare la risposta a una specifica richiesta. C’è da scommettere che, prima o dopo, diventerà a pagamento proprio come la versione veloce e illimitata di ChatGPT.

Tutto risolto, quindi? Non esattamente. Alla fine di gennaio la stessa OpenAI avvisava che il suo sistema aveva identificato il 26% di testi scritti dall’AI come “probabilmente” realizzati da un sistema artificiale e indicato (fatto ben più grave) un mica tanto insignificante 9% di falsi positivi, cioè testi prodotti da esseri umani etichettati invece come artificiali. Insomma, c’è molta strada da fare ma come noto la pachidermica mole di contenuti analizzata aiuterà AI Text Classifier a migliorare settimana dopo settimana, come il gemello demiurgo. Abbiamo fatto un test e questa incertezza in effetti è evidente: a un breve testo scritto di nostro pugno la piattaforma ha risposto che “non è chiaro se si tratti di un contenuto prodotto dall’intelligenza artificiale”. A uno prodotto dall’intelligenza artificiale ha invece risposto di trattarsi “probabilmente” di un testo generato dall’AI.

Tutto risolto, quindi? Non esattamente. Alla fine di gennaio la stessa OpenAI avvisava che il suo sistema aveva identificato il 26% di testi scritti dall’AI come “probabilmente” realizzati da un sistema artificiale e indicato (fatto ben più grave) un mica tanto insignificante 9% di falsi positivi, cioè testi prodotti da esseri umani etichettati invece come artificiali. Insomma, c’è molta strada da fare ma come noto la pachidermica mole di contenuti analizzata aiuterà AI Text Classifier a migliorare settimana dopo settimana, come il gemello demiurgo. Abbiamo fatto un test e questa incertezza in effetti è evidente: a un breve testo scritto di nostro pugno la piattaforma ha risposto che “non è chiaro se si tratti di un contenuto prodotto dall’intelligenza artificiale”. A uno prodotto dall’intelligenza artificiale ha invece risposto di trattarsi “probabilmente” di un testo generato dall’AI.

GPTZero

Esistono anche altri sistemi per provare a orientarsi nell’incertezza rispetto ai contenuti. Uno è per esempio GPTZero, realizzato da Edward Tian, uno studente dell’università di Princeton. La piattaforma “è un modello di classificazione che prevede se un documento è stato scritto da un modello di linguaggio di grandi dimensioni, fornendo previsioni a livello di frase, paragrafo e documento – si legge nelle faq – è stato addestrato su un corpus ampio e diversificato di testo scritto dall’uomo e generato dall’intelligenza artificiale, con particolare attenzione alla prosa inglese”. Ha già superato un milione di utenti e lo abbiamo messo alla prova: sul testo che AI Text Classifier aveva segnalato come incerto GPTZero ha correttamente indicato l’origine umana. Su quello prodotto da ChatGPT, però, è miseramente caduto in errore segnalandolo, anch’esso, come prodotto da un essere umano in carne e ossa. Una bella delusione.

ZeroGPT

C’è anche uno strumento quasi omonimo, ZeroGPT, che sfrutta la tecnologia DeepAnalyse per identificare l’origine. Anche in questo caso le istruzioni avvisano che gli esperimenti sono ancora in corso e che l’obiettivo è analizzare più di 1 miliardo di articoli e testi e “convergere verso un tasso di errore inferiore all’1%”. Nel nostro test il paragrafo scritto da un essere umano è stato definito tale e quello di ChatGPT pure.

Gpt-2 Output Detector

GPT-2 Output Detector è un tool ancora più semplice, dedicato proprio a ChatGPT: in questo caso il testo umano è stato definito al 99,98% come “reale” – qui si usa una scala percentuale con una barra colorata in calce alla finestra in cui inserire il testo – così come quello finto, che fra l’altro (dedicato alla storia della squadra della Roma) conteneva anche un errore su un allenatore del passato. Stessa percentuale e stessa delusione.

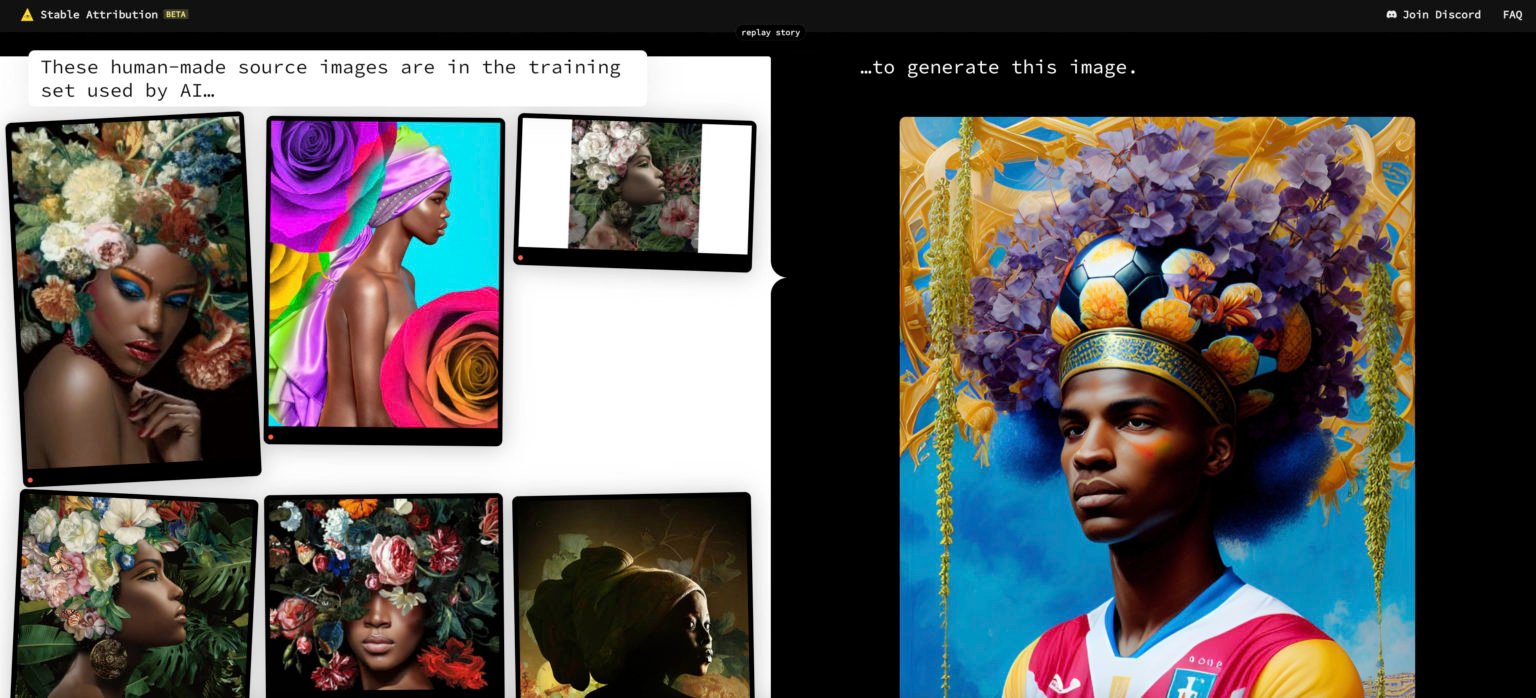

Stable Attribution

Passando alle immagini, invece, il tema più scottante sembra essere quello dell’attribuzione. Cioè delle infinite fonti alle quali sistemi come Stable Diffusion attingono per partorire un’illustrazione nuova di zecca. La piattaforma Stable Attribution tenta di identificare le immagini di partenza per ogni contenuto sfornato dall’AI, individuando una parte del dataset d’origine. Lo abbiamo provato con un’immagine realizzata su Dream.ai – piattaforma che nel frattempo ha introdotto una serie di piani a pagamento – e in effetti ci ha restituito una serie di riferimenti di partenza utilizzati dal machine learning per allenarsi.

Sempre per le immagini si possono invece impiegare Sightengine o Fakespot che sono però a pagamento e con funzionalità differenti l’una dall’altra: l’ultima serve per esempio a individuare nello specifico le recensioni fasulle, ad esempio sui siti di e-commerce, mentre Sightengine è un tool di moderazione automatizzata, che dunque blocca e individua contenuti inappropriati fra i quali quelli eventualmente (ma non necessariamente) generati dall’intelligenza artificiale. C’è dunque ampio margine di crescita nel settore del “controspionaggio” dei contenuti sia per i testi, soprattutto in termini di affidabilità visto che cadono troppo spesso in errore anche su frammenti brevi e semplici, che per le immagini, dove invece di sistemi a disposizione ce ne sono davvero pochi.